从黑箱到透明:可解释AI如何改变人工智能应用

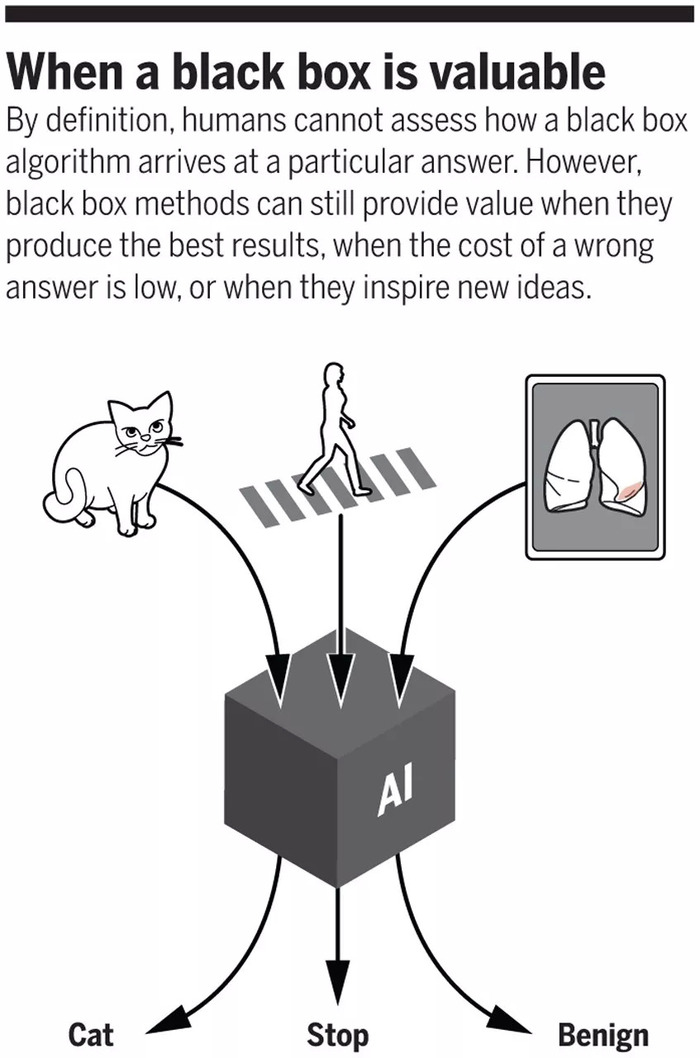

在人工智能领域中,有一类模型因其“黑箱”性质而长期饱受争议。这些模型虽然在许多任务上表现卓越,但其内部运作过程却难以被人类理解。这种不透明性不仅阻碍了人们对算法的信任,还限制了它们在某些关键领域的应用。近年来,随着可解释人工智能(Explainable AI, XAI)技术的发展,这一状况正在发生变化。本文将探讨可解释AI如何通过提高透明度和可理解性来改变人工智能的应用。

传统的机器学习模型,如深度神经网络,通常被视为“黑箱”。这意味着尽管我们能够观察到输入和输出之间的关系,但却无法深入了解模型是如何得出这些结果的。这种不透明性带来了几个问题:

缺乏信任:由于不了解模型的工作原理,用户往往对其决策持怀疑态度。这尤其适用于医疗诊断、金融审批等高风险场景。

难以调试和改进:当模型出现错误时,开发者很难找出具体的原因并进行修正。

法律和伦理问题:在一些国家和地区,法律规定企业需要对其决策过程负责。对于黑箱模型来说,这几乎是不可能做到的。

可解释AI旨在创建一种机制,使人类能够理解和验证AI系统的决策过程。它的目标是提供一个清晰、简洁且易于理解的描述,解释为什么某个特定的输入会导致某个特定的输出。通过这种方式,可解释AI可以帮助解决上述提到的问题,从而促进AI技术更广泛地应用于各个行业。

目前,研究人员提出了多种方法来实现可解释AI,主要包括以下几种:

局部可解释模型:这种方法并不试图解释整个模型,而是专注于解释单个预测。例如,LIME(Local Interpretable Model-agnostic Explanations)通过生成一个简单的线性模型来近似原始复杂模型的行为。

全局可解释模型:与局部可解释模型不同,这种方法试图解释整个模型的行为。SHAP(SHapley Additive exPlanations)是一种常用的全局可解释方法,它基于博弈论中的Shapley值概念,为每个特征分配一个权重,以反映其对预测结果的影响。

模型结构可解释性:这种方法涉及修改模型的设计,使其更容易被人类理解。例如,决策树和规则列表就是典型的例子,它们以直观的方式展示了数据是如何被分类或分组的。

随着可解释AI技术的进步,越来越多的行业开始将其应用于实际场景中。以下是几个具体的例子:

医疗保健:医生可以使用可解释AI系统来辅助诊断疾病,确保他们了解模型的决策过程。这样不仅可以提高治疗效果,还可以增强患者的信心。

金融服务:银行和保险公司可以利用可解释AI系统来进行信用评分和欺诈检测。这有助于减少歧视性做法,并提高客户的满意度。

智能城市:政府机构可以使用可解释AI系统来优化交通流量管理、能源消耗等。通过更好地理解模型的决策过程,他们可以制定出更加有效的政策。

教育:教师可以使用可解释AI系统来个性化教学计划,根据每个学生的特点为其推荐合适的课程内容。这有助于提高学习效率,促进个性化教育的发展。

尽管可解释AI带来了许多好处,但它也面临着一些挑战。当前大多数可解释AI方法仅适用于特定类型的任务或模型,尚未形成统一的标准。随着模型变得越来越复杂,如何保持解释的准确性和效率是一个亟待解决的问题。如何平衡模型性能与解释性的需求也是一个重要的研究方向。

展望未来,我们可以期待看到更多创新性的解决方案出现。例如,结合自然语言处理技术,开发出能够用自然语言解释模型行为的工具;或者探索新的数学理论,为解释复杂模型提供更强有力的支持。

标签: 从黑箱到透明、 可解释AI如何改变人工智能应用、本文地址: https://www.2drx.com/hlwzxwz/53dd62e59bdde53b9451.html

上一篇:AI芯片崛起驱动未来科技革命的核心力量...